[论文笔记]Batch Normalization

作者: 时间:2023-08-12阅读数:人阅读

引言

本文是论文神作Batch Normalization的阅读笔记,这篇论文引用量现在快50K了。

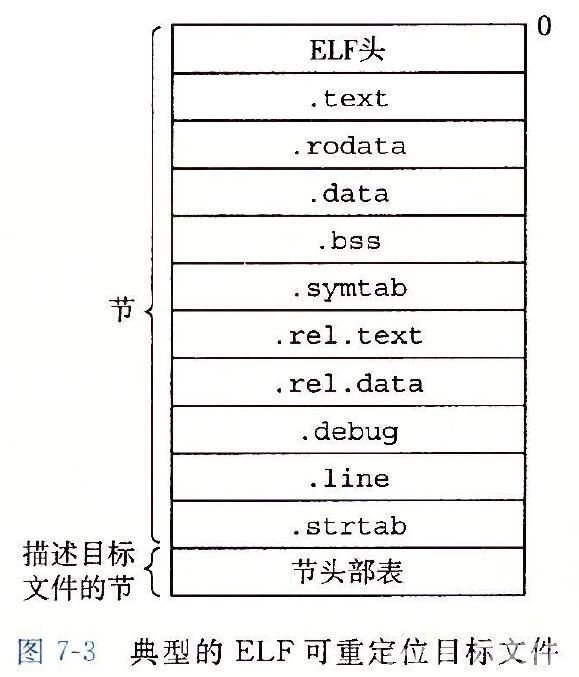

由于上一层参数的变化,导致每层输入的分布会在训练期间发生变化,让训练深层神经网络很复杂。这会拖慢训练速度,因为需要更低的学习率并小心地进行参数初始化,使得很难训练这种具有非线性饱和的模型。这种现象作者称为internal covariate shift(内部协变量偏移,ICS),并通过对网络层的输入进行归一化解决。这种方法之所以强大,是因为将归一化作为模型架构的一部分,并在每个训练小批量中执行归一化。

批归一化(Batch Normalization)可以让我们选择更高的学习率,并且不需要那么注意参数初始化。

简介

SGD和它的变体被用于训练深层网络,优化网络参数 Θ \Theta Θ来最小化损失:

本站所有文章、数据、图片均来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知我们删除。邮箱:licqi@yunshuaiweb.com